Indice

- 1 Sviluppato un sistema dotato di Intelligenza artificiale che traduce in tempo reale il vocale captato anche in ambienti dove ci sono più persone

- 2 Come funziona la traduzione vocale spaziale in tempo reale

- 3 Tre innovazioni chiave rendono il sistema unico

- 4 Test in ambienti reali e preferenze degli utenti

- 5 Verso un mondo senza barriere linguistiche

Sviluppato un sistema dotato di Intelligenza artificiale che traduce in tempo reale il vocale captato anche in ambienti dove ci sono più persone

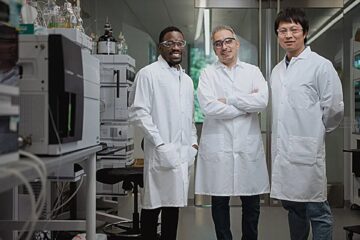

Immagina di poter capire chiunque, in qualunque lingua, semplicemente indossando delle cuffie. Non è fantascienza: un gruppo di ricercatori dell’Università di Washington ha progettato un sistema che permette la traduzione simultanea di più voci, con audio spaziale e clonazione vocale. Tutto è nato da un’esperienza reale: durante una visita in un museo in Messico, Tuochao Chen – dottorando dell’ateneo americano – ha tentato di usare un’app per tradurre la guida turistica, ma il rumore ambientale ha compromesso tutto. Da quella frustrazione è nato Spatial Speech Translation, un progetto che utilizza cuffie comuni con cancellazione del rumore e microfoni integrati, abbinate ad algoritmi in grado di tradurre più persone contemporaneamente, mantenendo voce, volume e direzione, con un ritardo minimo di 2–4 secondi.

Come funziona la traduzione vocale spaziale in tempo reale

A differenza di altri dispositivi, come gli occhiali smart di Meta che traducono una sola voce per volta e solo dopo che il parlante ha concluso, il sistema sviluppato a Washington riconosce e separa più voci in tempo reale. Gli algoritmi incorporati scansionano l’ambiente a 360 gradi, come un radar, e individuano quante persone stanno parlando e da dove provengono.

Il sistema riesce a seguire i movimenti dei parlanti, mantenendo invariata la loro voce, il volume e la direzione, anche mentre si spostano nello spazio. Inoltre, funziona su dispositivi mobili con chip Apple M2, come laptop o visori Apple Vision Pro, senza fare affidamento sul cloud, così da evitare problemi di privacy legati alla clonazione vocale.

Tre innovazioni chiave rendono il sistema unico

La prima innovazione consiste nel rilevare immediatamente il numero di interlocutori in uno spazio chiuso o aperto, distinguendoli anche se parlano simultaneamente. “I nostri algoritmi funzionano un po’ come un radar”, spiega Chen, “scansionano lo spazio continuamente per capire se c’è una sola persona o sei o sette”.

La seconda innovazione riguarda la fedeltà vocale: la voce tradotta mantiene le caratteristiche espressive dell’originale, un dettaglio che rende il dialogo più umano e realistico. Infine, quando le persone muovono la testa o cambiano posizione, il sistema continua a seguirle con precisione, senza perdere la qualità della traduzione.

Test in ambienti reali e preferenze degli utenti

Durante la sperimentazione, il sistema è stato testato in 10 ambienti diversi, sia al chiuso che all’aperto. In un test con 29 partecipanti, la maggior parte ha preferito il nuovo sistema rispetto a modelli che non seguono le persone nello spazio. Inoltre, un ulteriore test ha mostrato che il ritardo ideale per la traduzione è tra i 3 e i 4 secondi, dato che traduzioni più rapide portavano a maggiori errori.

Il sistema, al momento, funziona solo con linguaggio quotidiano, ma è in grado di tradurre spagnolo, francese e tedesco, con la possibilità di espandere a oltre 100 lingue in futuro, grazie a modelli di apprendimento preesistenti.

Verso un mondo senza barriere linguistiche

“Questo è un passo avanti verso l’abbattimento delle barriere tra le culture”, ha affermato Chen. “Se cammino per strada in Messico e non parlo spagnolo, grazie a questo sistema posso capire chi ha detto cosa attorno a me”.

Oltre a Chen, tra gli autori dello studio compaiono anche Qirui Wang, ricercatore di HydroX AI, e Runlin He, entrambi parte della Paul G. Allen School dell’Università di Washington. La ricerca è stata presentata il 30 aprile alla conferenza ACM CHI su fattori umani e sistemi informatici a Yokohama, in Giappone. Il codice del prototipo è stato reso pubblico per consentire ad altri ricercatori di sviluppare la tecnologia.

Fonte:

Proceedings of the 2025 CHI Conference on Human Factors in Computing Systems